Shadow IT

|

24 nov 2025

|

3 min read

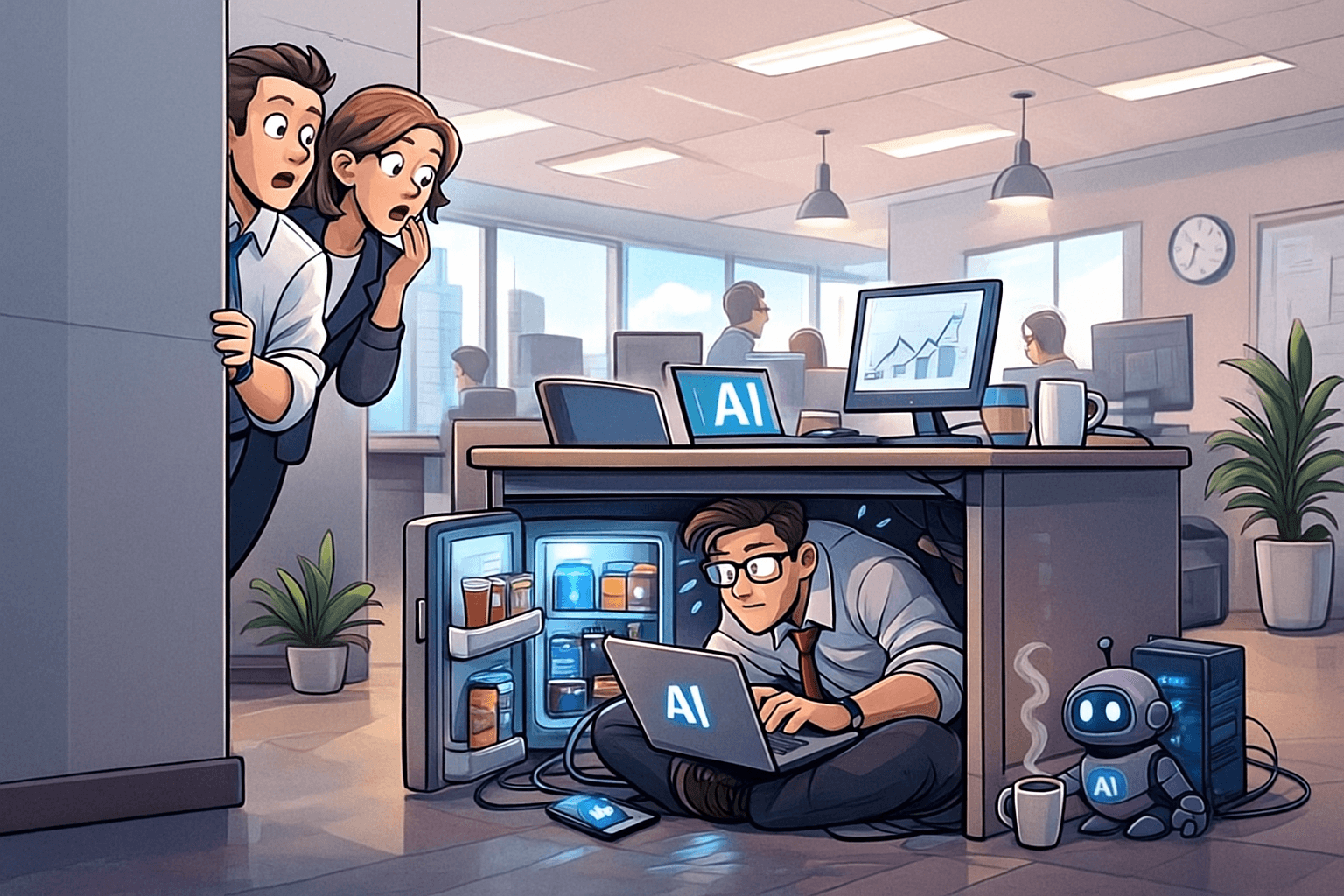

Shadow AI klinkt spannender dan het is: medewerkers die AI-tools gebruiken zonder dat IT het weet. Een beetje zoals stiekem een tweede koelkast in de schuur… totdat de energierekening binnenkomt. In de praktijk zien we dat Shadow AI vooral ontstaat uit frustratie: medewerkers hebben behoefte aan snelheid, automatisering en assistentie, maar de formele middelen voelen te traag of te complex.

Technisch gezien is dit geen klein risico. Niet geregistreerde AI-tools verwerken bedrijfsdata buiten zicht van security-controles. Wanneer AI-tools data uploaden naar niet-gecontroleerde modellen, ontstaat een cocktail van datalekrisico’s, IP-exposure en complianceproblemen.

Wat werkt wel? Organisaties die Shadow AI volwassen aanpakken starten met zichtbaarheid: welke tools worden gebruikt, welke data gaat erin en welke beleidskaders ontbreken? Tijdens onze Security Gap Analyses zien we steeds vaker dat organisaties Shadow IT en Shadow AI slechts beperkt in kaart hebben. In de Best Practices-methodiek van Amitron is Shadow IT-detectie zelfs een afzonderlijk onderdeel, omdat risico’s pas beheersbaar worden wanneer je weet waar data daadwerkelijk belandt.

Een praktijkvoorbeeld van de afgelopen jaren maakt dit concreet: bij meerdere Europese organisaties werd bedrijfsgevoelige informatie ingevoerd in publieke AI-chatbots, waarna delen van die input via modeltraining potentieel reproduceerbaar werden. Verschillende toezichthouders hebben hier in 2023 en 2024 officiële waarschuwingen voor uitgegeven (bron: European Data Protection Board, 2024 public advisory).

De vraag is dus niet hoe Shadow IT ontstaat, maar hoe snel je het zichtbaar maakt.

Hoe groot acht jij het risico dat binnen jouw organisatie al AI-tools worden gebruikt die niemand officieel heeft goedgekeurd?

Cybersecurity is hard werken

Ontdek hoe we uw organisatie kunnen beschermen — zonder onnodige complexiteit.